Ziele und Ergebnisse

Der Kontext

Im Herzen Deutschlands, in einem geschäftigen Technologiezentrum, befand sich ein kühnes Startup-Unternehmen mit einer Vision, die die digitale Landschaft umgestalten könnte. Dieses innovative Unternehmen, das für seine innovative Arbeit im Bereich der künstlichen Intelligenz bekannt ist, hatte sich etwas wirklich Außergewöhnliches zum Ziel gesetzt. Sie wollten ein KI-Sprachmodell entwickeln, das mit dem legendären ChatGPT konkurrieren konnte, aber mit einer Besonderheit: Es sollte vollständig über ihr eigenes Netzwerk laufen.

Es handelte sich nicht um ein gewöhnliches Projekt. Das Startup hatte bereits mit seiner bahnbrechenden App für Aufsehen gesorgt, einem eleganten und ausgeklügelten Chatbot, der eine menschenähnliche Konversation nachbilden sollte. Stellen Sie sich einen digitalen Begleiter vor, der so intuitiv und scharfsinnig ist, dass er Ihre Fragen versteht und mit der gleichen Nuance und Tiefe antwortet wie ein erfahrener Experte.

Aber wie haben sie das geschafft? Das Geheimnis lag in ihrer Beherrschung des maschinellen Lernens. Sie hatten komplexe Algorithmen entwickelt, die es ihrer KI ermöglichten, Sprache aus riesigen Datenmengen zu lernen, Muster zu erkennen und Entscheidungen im Handumdrehen zu treffen. Im Gegensatz zu herkömmlicher Software, die für jedes mögliche Szenario programmiert werden muss, konnte ihre KI selbständig denken und sich bei jeder neuen Interaktion anpassen und weiterentwickeln.

Die App hatte sich bereits den Ruf erworben, blitzschnelle Antworten selbst auf die schwierigsten Anfragen zu liefern. Ihre Wissensbasis war umfangreich und schöpfte aus einem Internet von Informationen, um den Nutzern präzise, kontextbezogene Antworten zu geben. Ganz gleich, ob Sie nach den Geheimnissen des Universums oder den neuesten Technologietrends fragten, diese KI hatte die richtige Antwort für Sie.

Als das Startup seine Kreation weiter verfeinerte, wurde klar, dass sie kurz vor etwas Revolutionärem standen. Ihr KI-Tool sollte nicht nur Fragen beantworten, sondern auch die Art und Weise verändern, wie Menschen mit Informationen umgehen. Mit seiner benutzerfreundlichen Oberfläche und seiner unvergleichlichen Genauigkeit wurde es schnell zu einer unverzichtbaren Ressource für alle, die schnelle und zuverlässige Antworten benötigten.

Der Traum des deutschen Start-ups war mehr als nur eine technische Errungenschaft, er war ein Sprung nach vorn in der Art und Weise, wie wir KI verstehen und nutzen. Als sie sich darauf vorbereiteten, ihre Vision auf ihren eigenen Servern zum Leben zu erwecken, wussten sie, dass sie im Begriff waren, Geschichte zu schreiben.

Problem

Es stand viel auf dem Spiel. Der Kunde, ein Visionär in der Welt der KI, hatte einen Traum, der nichts Geringeres als Spitzentechnologie erforderte. Er brauchte einen Server - einen Moloch an Rechenleistung -, der es mit den Titanen der KI-Welt aufnehmen konnte: LLaMA von Meta, Gemini von Google und Mistral. Es handelt sich dabei nicht um irgendwelche Sprachmodelle, sondern um die Spitzenmodelle der modernen KI, die eine immense Rechenleistung erfordern, um die Datenmenge eines ganzen Internets punktgenau zu verarbeiten und zu analysieren.

In der Welt der KI ist Leistung nicht nur ein Luxus, sondern eine Notwendigkeit. Der Kunde wusste, dass sein Server eine Maschine sein musste, die in der Lage war, intensive Arbeitslasten ohne das geringste Flackern von Instabilität zu bewältigen, um das volle Potenzial dieser Modelle auszuschöpfen. Die kleinste Störung könnte eine Katastrophe bedeuten, die den nahtlosen Informationsfluss unterbricht und zu frustrierenden Verzögerungen oder, schlimmer noch, zu ungenauen Ergebnissen führt. Doch mit dem richtigen Server, der auf Langlebigkeit und Leistung ausgelegt ist, konnte der Kunde die volle Leistung seiner KI-Lösung freisetzen und blitzschnelle, zuverlässige Antworten liefern - jedes Mal.

Der Bedarf an Leistung beschränkte sich jedoch nicht nur auf die reine Performance. Der Kunde wusste auch, dass sich die Welt der KI ständig verändert und neue Erkenntnisse und Durchbrüche in einem unaufhaltsamen Tempo entstehen. Um an der Spitze zu bleiben, musste sich die KI-Lösung ebenso schnell weiterentwickeln und die neuesten Fortschritte integrieren, um scharf, relevant und erstaunlich genau zu bleiben. Das bedeutete regelmäßige Updates und ein ständiges Bemühen um Perfektion. Und nur ein Server mit der Kapazität für kontinuierliche, effiziente Updates konnte sicherstellen, dass die KI immer auf dem neuesten Stand war und die nächste wichtige Frage beantworten konnte.

Für diesen Kunden war der Server nicht nur Hardware, sondern auch das Herzstück seines KI-Imperiums, der Schlüssel zur Verwirklichung einer Vision. Mit einem Server, der diese immensen Anforderungen erfüllen konnte, würde der Kunde nicht nur die Grenzen der KI verschieben, sondern auch die Zukunft der intelligenten Technologie neu definieren.

Lösung

In der Welt der KI, in der viel auf dem Spiel steht, ist Geschwindigkeit alles. Wenn es darum geht, ein KI-Sprachmodell zu betreiben, kann die Fähigkeit, Informationen blitzschnell zu verarbeiten, den Unterschied zwischen Brillanz und Mittelmäßigkeit bedeuten. Die Herausforderung ist immens: ein Internet von Daten zu durchforsten, sie in Echtzeit zu analysieren und Erkenntnisse mit Präzision zu liefern - und das alles in einem Wimpernschlag.

Um diese Herausforderung zu meistern, brauchten wir mehr als nur ein leistungsfähiges System; wir brauchten ein technologisches Meisterwerk. Deshalb haben wir uns für einen Server entschieden, der mit dem NVIDIA Tesla V100-Grafikprozessor ausgestattet ist, einem Ungetüm, das für seine unvergleichliche Leistung bekannt ist. Dies ist nicht irgendein Grafikprozessor, sondern die Spitze der NVIDIA-Produktpalette, angetrieben von der fortschrittlichen Tensor Core-Technologie, die die KI-Verarbeitung auf die nächste Stufe hebt.

Stellen Sie sich eine Maschine vor, die so leistungsfähig ist, dass sie selbst die komplexesten KI-Aufgaben mühelos bewältigen kann und Daten mit atemberaubender Geschwindigkeit verarbeitet. Der Tesla V100 wurde entwickelt, um den Anforderungen moderner KI gerecht zu werden, und ist damit die perfekte Wahl für alle Szenarien, in denen eine schnelle Datenverarbeitung mit hohem Volumen unabdingbar ist. Mit diesem Grafikprozessor als Herzstück wird das KI-Sprachmodell zu einer Kraft, mit der man rechnen muss und die Ergebnisse schneller und genauer als je zuvor liefert.

In den Händen dieses Kraftpakets ist die KI nicht nur reaktionsschnell, sondern auch hochleistungsfähig und bereit, die kompliziertesten Herausforderungen mit Finesse zu meistern. Der Tesla V100 erfüllt nicht nur die Anforderungen an die KI, er übertrifft sie sogar und setzt damit neue Maßstäbe in der Welt der intelligenten Technologie.

Der Prozess der Auswahl der Serverkonfiguration

Der Prozess zur Auswahl der idealen Serverkonfiguration für unseren Kunden sah wie folgt aus:

Nachdem wir die notwendigen Informationen über die gewünschten Aufgaben des Kunden eingeholt hatten, erstellten wir eine maßgeschneiderte Konfiguration, die die spezifischen Anforderungen erfüllt und eine effiziente Verarbeitung großer Datenmengen für das Training von KI-Modellen gewährleistet.

Die ursprüngliche Konfiguration, die wir vorschlugen, sah wie folgt aus (beachten Sie, dass sie je nach den Präferenzen des Kunden angepasst werden kann)

-Prozessor: 2 x Intel Xeon Gold 6248R

-ARBEITSSPEICHER: 512 GB DDR4

- Speicher: 4 TB SSD NVMe

- Grafikkarten: 4x NVIDIA Tesla V100

Vor der Auslieferung der endgültigen Serverlösung war es notwendig, die kundenorientierte Serverkonfiguration weiter zu verfeinern. Zu diesem Zweck haben wir eine Umfrage gestartet, um Informationen zu den folgenden Aspekten zu sammeln:

- Die geplante Datenmenge, die verarbeitet und mit dem KI-Modell trainiert werden soll.

- Präferenzen hinsichtlich bestimmter GPUs und anderer wichtiger Komponenten.

Nachdem wir zusätzlichen Input vom Kunden bezüglich seines Datenvolumens und seiner Hardwarepräferenzen erhalten hatten, schlugen wir eine endgültige Serverkonfiguration vor, die die folgenden spezifischen Anforderungen erfüllte.

- Server-Miete: In Anbetracht der ursprünglichen Anforderungen des Kunden benötigte die Konfiguration leistungsstarke Prozessoren, eine große Menge an RAM und mehrere Grafikkarten.

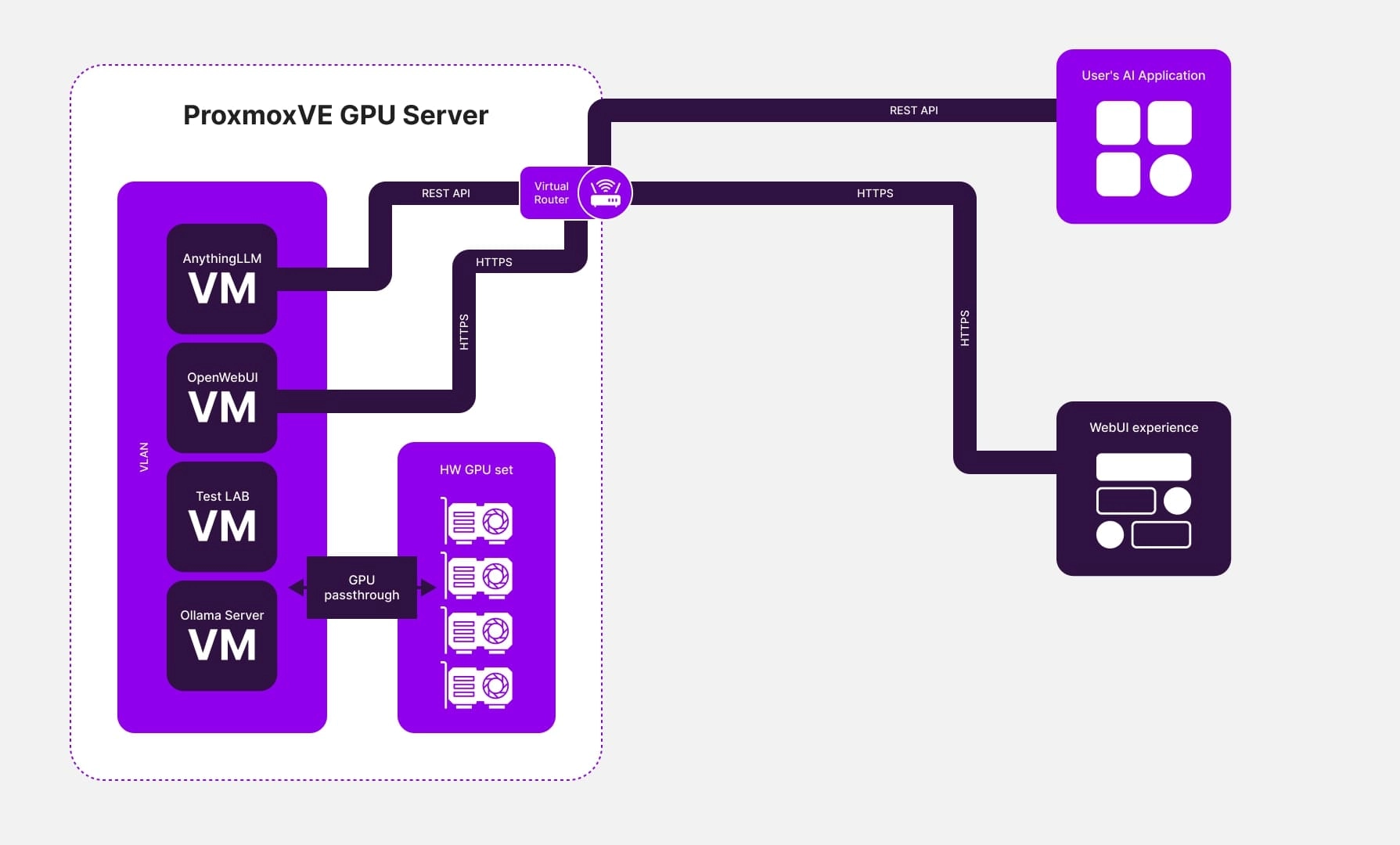

- Einsatz von Virtualisierungssoftware: Um den Anforderungen des Kunden gerecht zu werden, implementierten wir eine virtualisierungsbasierte Infrastruktur. Diese Infrastruktur umfasste mehrere virtuelle Maschinen, die jeweils mit eigenen Grafikkarten ausgestattet waren.

- Installation von Sprachmodell-Servern: Die Sprachmodell-Server Ollama und OpenWebUI wurden auf den virtuellen Maschinen installiert, zusammen mit einem Server, der Zugang zu einer benutzerfreundlichen und sicheren Web-UI für die Verwaltung der Sprachmodelle bot, wie z. B. AnythingLLM. AnythingLLM bot auch API-Zugang für die Integration mit anderen Client-Entwicklungen.

- Einführung des Modells: Der Kunde hat sein Modell der künstlichen Intelligenz erfolgreich gestartet und dabei einen stabilen Betrieb und eine hohe Leistung des Servers sichergestellt.

Fazit

Der Moment, in dem der Tesla V100 in den Server des Kunden integriert wurde, war wie die Entfesselung eines schlafenden Kraftwerks. Die Leistung des Servers hat sich nicht nur verbessert, sondern ist in die Höhe geschossen und hat die Grenzen herkömmlicher CPUs gesprengt. Mit den außergewöhnlichen GPU-Fähigkeiten des Tesla V100 gewann der Server eine noch nie dagewesene Leistung und einen noch nie dagewesenen Durchsatz und übertraf die Beschränkungen von Single-CPU-Systemen mit Leichtigkeit.

Bei diesem Technologiesprung ging es nicht nur um Hardware, sondern um die Umgestaltung des gesamten KI-Projekts des Kunden. Unser innovativer Ansatz zur Optimierung der Serverkonfiguration wurde zum Rückgrat des Erfolgs. Als das KI-Sprachmodell auf diesem turbogeladenen Server in Betrieb ging, waren die Ergebnisse geradezu spektakulär:

- Unerreichte Servicequalität

Die Fähigkeit der KI, schnelle und präzise Antworten zu liefern, machte einen Quantensprung. Die Nutzer erhielten schnellere und präzisere Antworten, und das Modell bewältigte selbst die komplexesten Abfragen mit Bravour. Dies war nicht nur ein Upgrade, sondern eine Revolution in Sachen Benutzerzufriedenheit und Serviceleistung.

- Gesteigerte Leistung

Das Training des KI-Modells wurde dank der immensen Rechenleistung, die ihm zur Verfügung steht, zu einem rationalisierten, effizienten Prozess. Große Datensätze, die früher die Systeme zum Erliegen brachten, wurden nun in rasender Geschwindigkeit verarbeitet, was die Trainingszeiten verkürzte und die Entwicklung des Modells beschleunigte. Die Implementierung der KI verlief schneller, reibungsloser und effektiver als je zuvor.

- Grenzenlose Skalierbarkeit

Die von uns konzipierte Serverarchitektur wurde nicht nur für die Gegenwart, sondern auch für die Zukunft entwickelt. Dank der im Kern integrierten Skalierbarkeit konnte der Kunde sein Projekt mühelos erweitern, wenn seine Benutzerbasis wuchs und die Anforderungen zunahmen. Diese Flexibilität sorgte dafür, dass sich die KI mit den Ambitionen des Kunden weiterentwickeln konnte, ohne dass drastische technische Überarbeitungen erforderlich waren.

Am Ende war dies nicht nur ein Projekt, sondern ein Erfolg. Durch die Integration des KI-Sprachmodells in den eigenen Server konnte der Kunde eine ganze Reihe von Vorteilen nutzen: eine erheblich verbesserte Servicequalität, eine höhere Leistung und eine robuste Skalierbarkeit. Diese Errungenschaften erfüllten nicht nur die Erwartungen, sondern setzten einen neuen Standard für das, was möglich ist, wenn Spitzentechnologie auf visionäre Umsetzung trifft. Die Zukunft der KI war da, und sie war heller als je zuvor.

![Proxmox VE Transformation: Wiedereinführung eines IT-Produktionssystems in einer gesicherten Infrastruktur [ожидает перевода].](/de/assets/components/phpthumbof/cache/proxmox-ve-transformation-case-study.3bb9018243fd9329b224801b3e0cb364.jpg)