Cele i wyniki

Kontekst

W samym sercu Niemiec, w tętniącym życiem centrum technologicznym, znajdował się odważny startup z wizją, która mogła zmienić cyfrowy krajobraz. Ta innowacyjna firma, znana z najnowocześniejszych prac w dziedzinie sztucznej inteligencji, postawiła sobie za cel coś naprawdę niezwykłego. Chcieli stworzyć model językowy sztucznej inteligencji, który mógłby rywalizować z legendarnym ChatGPT, ale z niespodzianką - musiał działać całkowicie w ich własnej sieci.

To nie był zwykły projekt. Startup zrobił już furorę dzięki swojej przełomowej aplikacji, eleganckiemu i wyrafinowanemu chatbotowi zaprojektowanemu do replikowania konwersacji podobnych do ludzkich. Wyobraź sobie cyfrowego towarzysza tak intuicyjnego, tak bystrego, że mógłby zrozumieć twoje pytania i odpowiedzieć z takim samym niuansem i głębią jak doświadczony ekspert.

Ale jak oni to zrobili? Sekret tkwił w ich mistrzostwie w uczeniu maszynowym. Opracowali złożone algorytmy, które pozwoliły ich sztucznej inteligencji uczyć się języka z ogromnych ilości danych, rozpoznawać wzorce i podejmować decyzje w locie. W przeciwieństwie do tradycyjnego oprogramowania, które musi być zaprogramowane na każdy możliwy scenariusz, ich sztuczna inteligencja mogła myśleć samodzielnie, dostosowując się i ewoluując z każdą nową interakcją.

Aplikacja zyskała już reputację błyskawicznie udzielającej odpowiedzi nawet na najtrudniejsze zapytania. Jej baza wiedzy była rozległa, czerpiąc z Internetu informacji, aby zapewnić użytkownikom precyzyjne, kontekstowo świadome odpowiedzi. Niezależnie od tego, czy pytałeś o tajemnice wszechświata, czy o najnowsze trendy w technologii, ta sztuczna inteligencja Cię obejmowała.

W miarę jak startup kontynuował udoskonalanie swojego dzieła, stało się jasne, że są u progu czegoś rewolucyjnego. Ich narzędzie AI nie polegało tylko na odpowiadaniu na pytania; chodziło o przekształcenie sposobu, w jaki ludzie wchodzili w interakcje z informacjami. Dzięki przyjaznemu dla użytkownika interfejsowi i niezrównanej dokładności szybko stało się niezbędnym źródłem informacji dla każdego, kto potrzebował szybkich i wiarygodnych odpowiedzi.

Marzenie niemieckiego startupu było czymś więcej niż tylko osiągnięciem technicznym, było skokiem naprzód w sposobie, w jaki rozumiemy i wykorzystujemy sztuczną inteligencję, a gdy przygotowywali się do urzeczywistnienia swojej wizji na własnych serwerach, wiedzieli, że wkrótce przejdą do historii.

Problem

Stawka była wysoka. Klient, wizjoner w świecie sztucznej inteligencji, miał marzenie, które wymagało jedynie najnowocześniejszej technologii. Potrzebował serwera - giganta mocy obliczeniowej - który mógłby stawić czoła tytanom świata sztucznej inteligencji: LLaMA firmy Meta, Gemini firmy Google i Mistral. To nie są zwykłe modele językowe; to szczyty nowoczesnej sztucznej inteligencji, wymagające ogromnej mocy obliczeniowej do przetwarzania i analizowania danych o wartości internetu z najwyższą dokładnością.

W świecie sztucznej inteligencji moc obliczeniowa to nie tylko luksus - to konieczność. Klient wiedział, że aby w pełni wykorzystać potencjał tych modeli, ich serwer musi być silnikiem, zdolnym do obsługi intensywnych obciążeń bez najmniejszych oznak niestabilności. Najmniejsza usterka mogłaby oznaczać katastrofę, zakłócając płynny przepływ informacji i prowadząc do frustrujących opóźnień lub, co gorsza, niedokładnych wyników. Jednak dzięki odpowiedniemu serwerowi, zbudowanemu z myślą o wytrzymałości i doskonałości, klient mógł odblokować pełną moc swojego rozwiązania AI, zapewniając błyskawiczne i niezawodne odpowiedzi za każdym razem.

Potrzeba mocy nie kończyła się jednak na samej wydajności. Klient rozumiał również, że świat sztucznej inteligencji nieustannie się zmienia, a nowa wiedza i przełomowe odkrycia pojawiają się w nieubłaganym tempie. Aby pozostać na czele, ich rozwiązanie AI musiało ewoluować równie szybko, uwzględniając najnowsze osiągnięcia, aby pozostać ostrym, istotnym i zadziwiająco dokładnym. Oznaczało to regularne aktualizacje i ciągłe dążenie do perfekcji. Ponadto tylko serwer z możliwością ciągłych, wydajnych aktualizacji mógł zapewnić, że sztuczna inteligencja pozostanie w czołówce, zawsze gotowa odpowiedzieć na kolejne ważne pytanie.

Dla tego klienta serwer nie był tylko sprzętem; był umysłem ich imperium AI, kluczem do przekształcenia wizji w rzeczywistość. Dzięki serwerowi, który mógłby sprostać tym ogromnym wymaganiom, klient nie tylko przesunąłby granice tego, co może zrobić sztuczna inteligencja, ale także na nowo zdefiniowałby przyszłość inteligentnej technologii.

Rozwiązanie

W świecie sztucznej inteligencji o wysoką stawkę szybkość jest wszystkim. Jeśli chodzi o uruchamianie modelu językowego AI, zdolność do błyskawicznego przetwarzania informacji może oznaczać różnicę między błyskotliwością a przeciętnością. Wyzwanie jest ogromne: przeszukać internet danych, przeanalizować je w czasie rzeczywistym i dostarczyć precyzyjnych spostrzeżeń - a wszystko to w mgnieniu oka.

Aby sprostać temu wyzwaniu, wiedzieliśmy, że potrzebujemy czegoś więcej niż tylko potężnego systemu; potrzebowaliśmy technologicznego arcydzieła. Dlatego też wybraliśmy serwer uzbrojony w układ GPU NVIDIA Tesla V100, bestię znaną z niezrównanej wydajności. To nie jest zwykły procesor graficzny - to szczytowe osiągnięcie w ofercie NVIDIA, napędzane zaawansowaną technologią Tensor Core, która przenosi przetwarzanie AI na wyższy poziom.

Wyobraź sobie maszynę tak potężną, że z łatwością poradzi sobie z najbardziej złożonymi zadaniami SI, bez wysiłku przetwarzając dane z oszałamiającą prędkością. Tesla V100 została zaprojektowana, aby sprostać wymaganiom nowoczesnej sztucznej inteligencji, co czyni ją idealnym wyborem dla każdego scenariusza, w którym szybkie przetwarzanie danych na dużą skalę nie podlega negocjacjom. Dzięki temu układowi GPU model języka sztucznej inteligencji staje się siłą, z którą należy się liczyć, zdolną do dostarczania wyników szybciej i dokładniej niż kiedykolwiek wcześniej.

W rękach tej potęgi, sztuczna inteligencja jest nie tylko responsywna - jest doładowana, gotowa do podjęcia najbardziej skomplikowanych wyzwań z finezją. Tesla V100 nie tylko spełnia wymagania sztucznej inteligencji, ale także je pokonuje, wyznaczając nowy standard tego, co jest możliwe w świecie inteligentnych technologii.

Proces wyboru konfiguracji serwera

Wracając do procesu wyboru idealnej konfiguracji serwera dla naszego klienta, wyglądał on następująco:

Po starannym zebraniu od klienta niezbędnych informacji dotyczących jego pożądanych zadań, dostarczyliśmy dopasowaną konfigurację spełniającą określone wymagania i zapewniającą wydajne przetwarzanie dużych ilości danych na potrzeby szkolenia modeli AI.

Początkowa konfiguracja, którą zaproponowaliśmy, była następująca (należy pamiętać, że można ją dostosować do preferencji klienta):

-Procesor: 2 x Intel Xeon Gold 6248R

-PAMIĘĆ RAM: 512 GB DDR4

- Pamięć masowa: 4 TB SSD NVMe

- Karty graficzne: 4x NVIDIA Tesla V100

Przed dostarczeniem ostatecznego rozwiązania serwerowego konieczne było dalsze dopracowanie konfiguracji serwera zorientowanej na klienta. Aby to osiągnąć, zainicjowaliśmy zapytanie w celu zebrania informacji na temat następujących aspektów:

- Planowana ilość danych do przetworzenia i wytrenowania na modelu AI.

- Preferencje dotyczące konkretnych procesorów graficznych i innych ważnych komponentów.

Po otrzymaniu dodatkowych informacji od klienta dotyczących ilości danych i preferencji sprzętowych, zaproponowaliśmy ostateczną konfigurację serwera, która spełniała następujące wymagania.

- Wynajem serwera: Biorąc pod uwagę początkowe wymagania klienta, konfiguracja wymagała wydajnych procesorów, dużej ilości pamięci RAM i kilku kart graficznych.

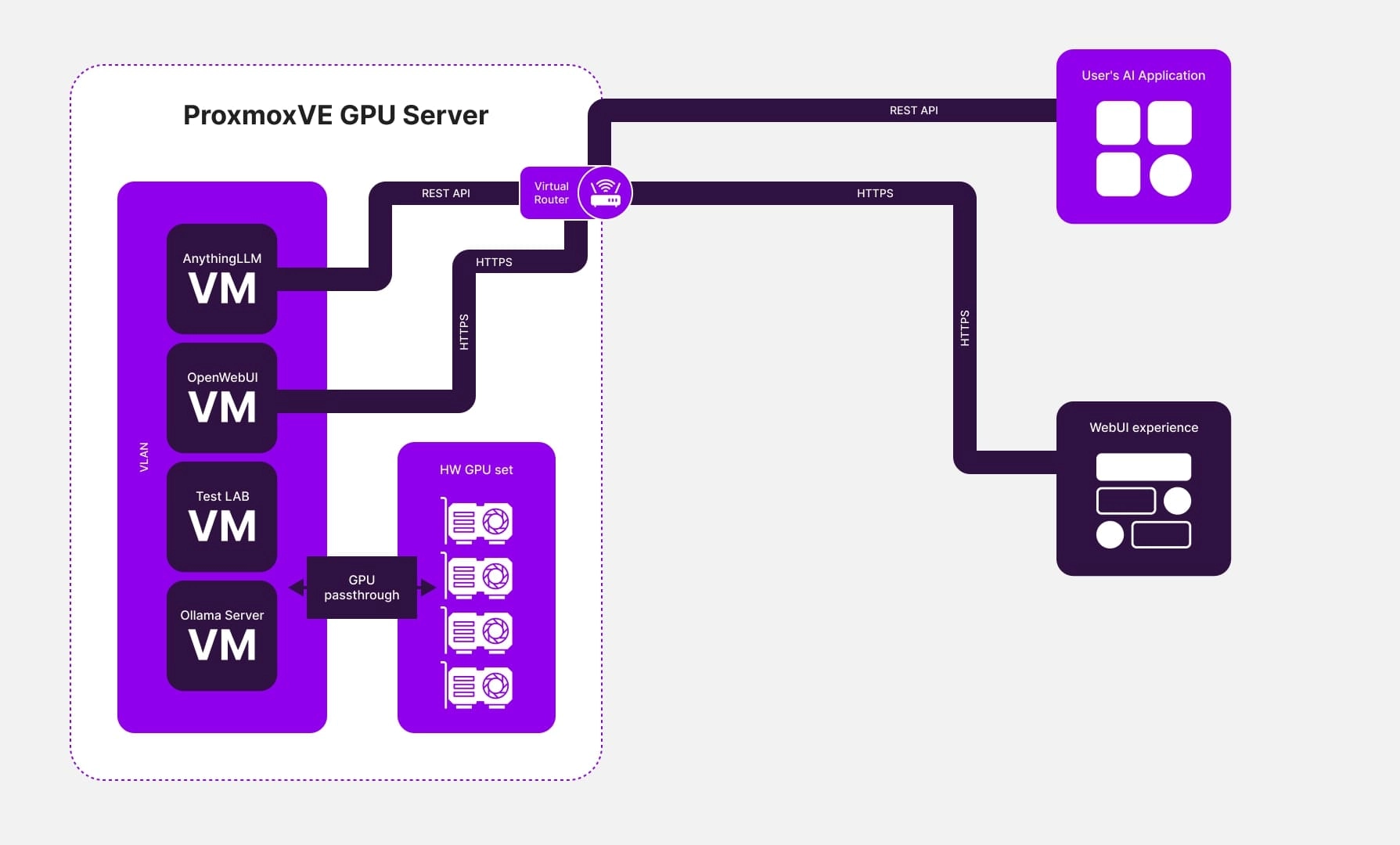

- Wykorzystanie oprogramowania do wirtualizacji: Aby spełnić potrzeby klienta, wdrożyliśmy infrastrukturę opartą na wirtualizacji. Konfiguracja ta obejmowała wiele maszyn wirtualnych, z których każda wyposażona była we własne karty graficzne.

- Instalacja serwerów modeli językowych: Serwery modeli językowych Ollama i OpenWebUI zostały zainstalowane na maszynach wirtualnych, wraz z serwerem, który zapewniał dostęp do przyjaznego dla użytkownika i bezpiecznego interfejsu internetowego do zarządzania modelami językowymi, takimi jak AnythingLLM. AnythingLLM oferował również dostęp do API w celu integracji z innymi rozwiązaniami klienckimi.

- Uruchomienie modelu: Klient z powodzeniem uruchomił swój model sztucznej inteligencji, zapewniając stabilne działanie i wysoką wydajność na serwerze.

Podsumowanie

Moment, w którym Tesla V100 została zintegrowana z serwerem klienta, był jak uwolnienie uśpionej potęgi. Wydajność serwera nie tylko wzrosła, ale wręcz poszybowała w górę, przełamując ograniczenia tradycyjnych procesorów. Dzięki niezwykłym możliwościom GPU Tesla V100, serwer zyskał bezprecedensową moc i przepustowość, z łatwością pokonując ograniczenia systemów z pojedynczym procesorem.

Ten skok technologiczny nie dotyczył tylko sprzętu; chodziło o przekształcenie całego projektu AI klienta. Nasze innowacyjne podejście do optymalizacji konfiguracji serwerów stało się podstawą ich sukcesu. Gdy model języka AI został uruchomiony na tym turbodoładowanym serwerze, wyniki były po prostu spektakularne:

- Niezrównana jakość usług

Zdolność sztucznej inteligencji do dostarczania szybkich, precyzyjnych odpowiedzi wykonała milowy krok. Użytkownicy zaczęli otrzymywać szybsze i dokładniejsze odpowiedzi, a model zręcznie radził sobie nawet z najbardziej złożonymi zapytaniami. To nie była tylko aktualizacja, to była rewolucja w zadowoleniu użytkowników i wydajności usług.

- Zwiększona wydajność

Trenowanie modelu AI stało się usprawnionym, wydajnym procesem dzięki ogromnej mocy obliczeniowej, jaką dysponował. Duże zbiory danych, które kiedyś obciążały systemy, były teraz przetwarzane z zawrotną prędkością, skracając czas szkolenia i przyspieszając ewolucję modelu. Wdrożenie sztucznej inteligencji było szybsze, płynniejsze i bardziej efektywne niż kiedykolwiek wcześniej.

- Nieograniczona skalowalność

Stworzona przez nas architektura serwerowa nie została zbudowana tylko na dziś, ale została zaprojektowana z myślą o przyszłości. Dzięki skalowalności wbudowanej w jej rdzeń, klient mógł bez wysiłku rozszerzyć swój projekt wraz ze wzrostem bazy użytkowników i rosnącymi wymaganiami. Ta elastyczność zapewniła, że sztuczna inteligencja mogła ewoluować wraz z ambicjami klienta, bez konieczności drastycznych zmian technicznych.

Ostatecznie nie był to tylko projekt - to był triumf. Integrując model językowy AI na własnym serwerze, klient odblokował trzy korzyści: znacznie lepszą jakość usług, zwiększoną wydajność i solidną skalowalność. Osiągnięcia te nie tylko spełniły oczekiwania; wyznaczyły nowy standard tego, co jest możliwe, gdy najnowocześniejsza technologia spotyka się z wizjonerską realizacją. Przyszłość AI nadeszła i była jaśniejsza niż kiedykolwiek.