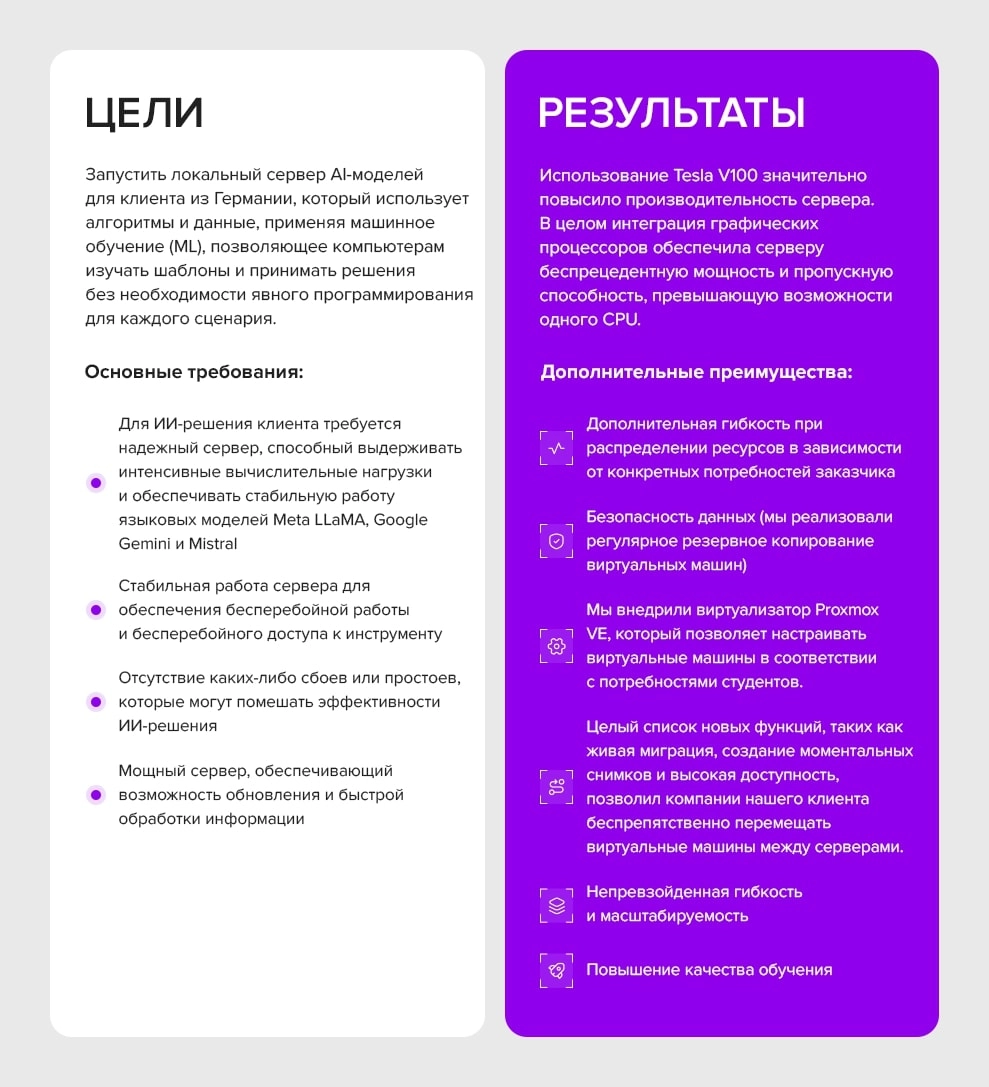

Цели & Результати

Контекст

В самом сердце Германии, в оживленном технологическом центре, находился смелый стартап с видением, которое могло изменить цифровой ландшафт. Эта инновационная компания, известная своими передовыми разработками в области искусственного интеллекта, нацелилась на нечто поистине экстраординарное. Они хотели создать модель языка искусственного интеллекта, которая могла бы конкурировать с легендарным ChatGPT, но с одной особенностью: она должна была работать полностью в их собственной сети.

Это был не просто обычный проект. Стартап уже произвел фурор своим новаторским приложением — сложным чат-ботом, предназначенным для имитации человеческого общения. Представьте себе цифрового компаньона, настолько интуитивного и острого, что он сможет понять ваши вопросы и ответить с той же нюансировкой и глубиной, что и опытный эксперт.

Но как они это сделали? Секрет заключался в их владении машинным обучением. Они разработали сложные алгоритмы, которые позволили их ИИ изучать язык на основе огромных объемов данных, распознавая закономерности и принимая решения на лету. В отличие от традиционного программного обеспечения, которое необходимо программировать для каждого возможного сценария, их ИИ мог думать сам за себя, адаптируясь и развиваясь при каждом новом взаимодействии.

Приложение уже заслужило репутацию молниеносно отвечающего даже на самые сложные запросы благодаря наличии обширной базы. Эта база черпала информацию из Интернета и предоставляла пользователям точные, контекстно-ориентированные ответы. Если вы спрашиваете о тайнах Вселенной или о последних тенденциях в области технологий, этот ИИ поможет вам.

По мере того как стартап продолжал совершенствовать свое творение, стало ясно, что они находятся на грани чего-то революционного. Их инструмент искусственного интеллекта не просто отвечал на вопросы; речь шла о преобразовании того, как люди взаимодействуют с информацией. Благодаря удобному интерфейсу и беспрецедентной точности приложение стало незаменимым ресурсом для всех, кому нужны быстрые и надежные ответы.

Мечта немецкого стартапа была чем-то большим, чем просто технические достижения - это был шаг вперед в том, как мы понимаем и используем ИИ, и, готовясь воплотить свое видение в жизнь, компания уже знала, что ей нужны надежные серверные решения.

Задача

Ставки были высоки. У клиента, провидца в мире искусственного интеллекта, была мечта, которая требовала не что иное, как передовые технологии. Им нужен был сервер — огромная вычислительная мощь, — который мог бы противостоять титанам мира искусственного интеллекта: LLaMA от Meta, Gemini от Google и Mistral. Это не просто языковые модели; они являются вершиной современного искусственного интеллекта, требующего огромных вычислительных мощностей для обработки и анализа данных Интернета с высочайшей точностью.

В мире искусственного интеллекта власть — это не просто роскошь, это необходимость. Клиент знал, что для полного раскрытия потенциала этих моделей его сервер должен быть механизмом, способным справляться с интенсивными рабочими нагрузками без малейшего намека на нестабильность. Малейший сбой может обернуться катастрофой, нарушить бесперебойный поток информации и привести к неприятным задержкам или, что еще хуже, к неточным результатам. Но с правильным сервером, созданным для того, чтобы выдерживать и превосходить других, клиент сможет раскрыть всю мощь своего решения искусственного интеллекта, каждый раз обеспечивая молниеносные и надежные ответы.

Тем не менее, потребность в мощности не ограничивалась чистой производительностью. Клиент также понимал, что мир искусственного интеллекта постоянно меняется: новые знания и прорывы появляются неустанно. Чтобы оставаться впереди, их решения на базе искусственного интеллекта должны были развиваться столь же быстро, включая последние достижения, чтобы оставаться острыми, актуальными и удивительно точными. Это означало регулярные обновления и постоянное стремление к совершенству. Кроме того, только сервер, способный осуществлять непрерывные и эффективные обновления, может гарантировать, что ИИ останется на переднем крае и всегда будет готов ответить на следующий важный вопрос.

Для этого клиента сервер был не просто оборудованием; это был разум их империи искусственного интеллекта, ключ к воплощению видения в реальность. В данном случаи наличия сервера, способного удовлетворить огромные требования пользователей, гарантировало клиенту не только возможность расширить границы возможностей ИИ, но и переопределить будущее интеллектуальных технологий.

Результат

В мире ИИ, где ставки высоки, скорость решает все. Когда дело доходит до запуска языковой модели искусственного интеллекта, способность молниеносно обрабатывать информацию может означать разницу между блеском и посредственностью. Задача огромна: просеивать данные в Интернете, анализировать их в режиме реального времени и предоставлять точные выводы — и все это в мгновение ока.

Мы знали, что для того, чтобы справиться с этой задачей, нам нужно нечто большее, чем просто мощная система; нам нужен был технологический шедевр. Вот почему мы выбрали сервер, оснащенный графическим процессором NVIDIA Tesla V100, чудовищной машиной, известной своей непревзойденной производительностью. Это не просто графический процессор — это вершина линейки NVIDIA, оснащенная передовой технологией Tensor Core, которая выводит обработку ИИ на новый уровень.

Представьте себе машину настолько мощную, что она может с легкостью решать самые сложные задачи искусственного интеллекта, без особых усилий обрабатывая данные с умопомрачительной скоростью. Tesla V100 разработан с учетом требований современного искусственного интеллекта, что делает его идеальным выбором для любого сценария, где быстрая обработка больших объемов данных не подлежит обсуждению. Благодаря этому графическому процессору языковая модель искусственного интеллекта становится силой, с которой нужно считаться, способной предоставлять результаты быстрее и точнее, чем когда-либо прежде.

В руках этой мощной машины ИИ не просто реагирует — он заряжен, готовый с ловкостью решать самые сложные задачи. Tesla V100 не просто отвечает требованиям искусственного интеллекта; он стирает их, устанавливая новый стандарт того, что возможно в мире интеллектуальных технологий.

Процесс выбора конфигурации сервера

Возвращаясь к процессу выбора идеальной конфигурации сервера для нашего заказчика, он выглядел следующим образом:

Тщательно собрав необходимую информацию от заказчика относительно желаемых задач, мы предоставили индивидуальную конфигурацию, отвечающую конкретным требованиям и обеспечивающую эффективную обработку больших объемов данных для обучения модели ИИ.

Предложенная нами первоначальная конфигурация была следующей (обратите внимание, что ее можно настроить в соответствии с предпочтениями клиента):

• Процессор: 2 x Intel Xeon Gold 6248R

• Оперативная память: 512 ГБ DDR4.

• Хранилище: 4 ТБ SSD NVMe.

• Видеокарты: 4 NVIDIA Tesla V100.

Прежде чем представить окончательное серверное решение, необходимо было доработать конфигурацию сервера, ориентированную на клиента. Для достижения этой цели мы инициировали расследование для сбора информации по следующим аспектам:

- Планируемый объем данных, подлежащих обработке и обучению на модели ИИ.

- Предпочтения относительно конкретных графических процессоров и других важных компонентов.

Получив дополнительную информацию от клиента относительно объема данных и предпочтений в оборудовании, мы предложили окончательную конфигурацию сервера, отвечающую следующим конкретным требованиям.

- Аренда сервера. Учитывая первоначальные требования клиента, для конфигурации требовались мощные процессоры, большой объем оперативной памяти и несколько видеокарт.<

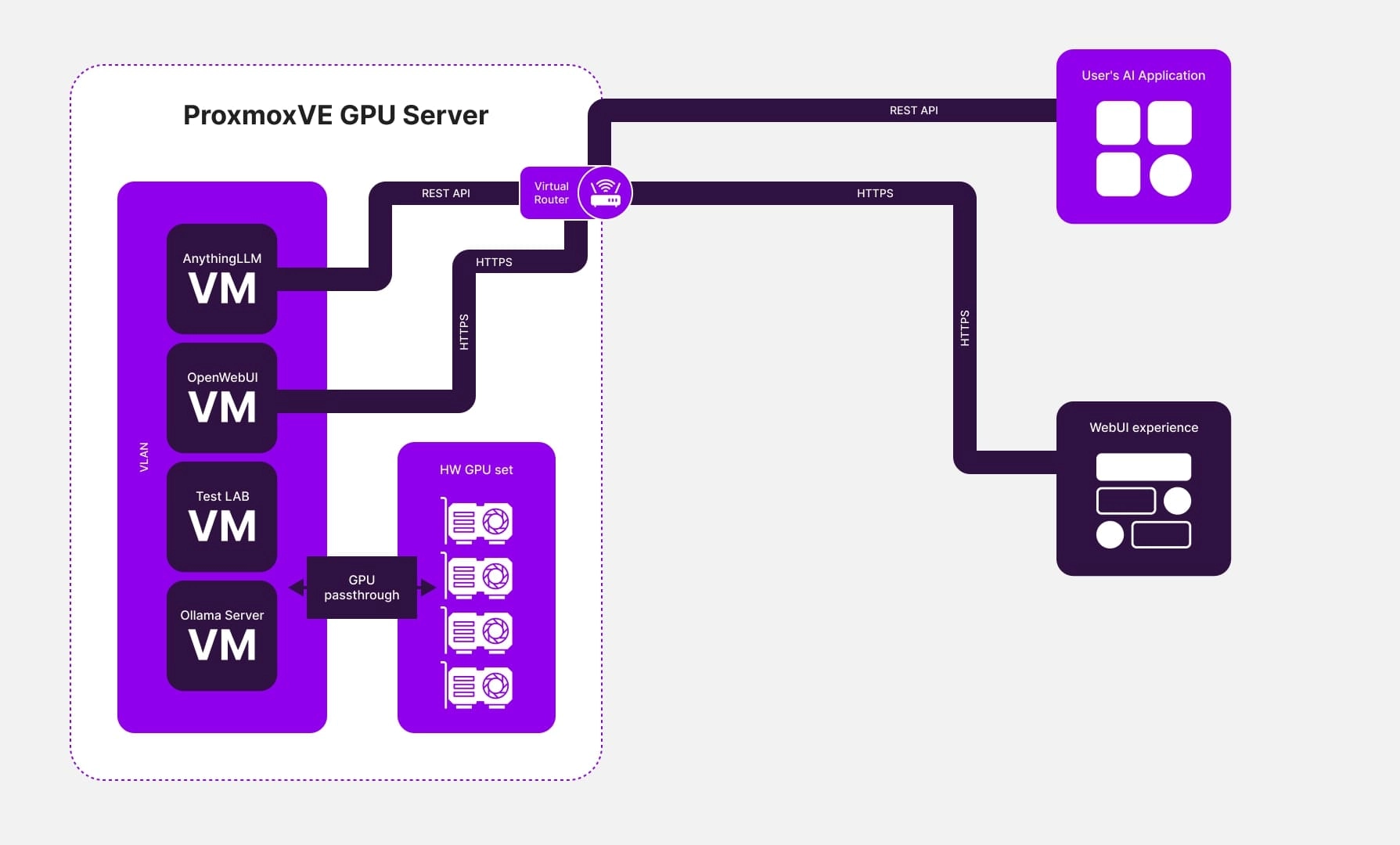

- Использование программного обеспечения для виртуализации. Чтобы удовлетворить потребности клиента, мы внедрили инфраструктуру на основе виртуализации. Эта установка включала несколько виртуальных машин, каждая из которых была оснащена собственными графическими адаптерами.

- Установка серверов языковых моделей. На виртуальные машины были установлены серверы языковых моделей Ollama и OpenWebUI, а также сервер, который обеспечивал доступ к удобному и безопасному веб-интерфейсу для управления языковыми моделями, например AnythingLLM. AnythingLLM также предлагал доступ к API для интеграции с другими клиентскими разработками.

- Запуск модели: клиент успешно запустил свою модель искусственного интеллекта, обеспечив стабильную работу и высокую производительность на сервере.

Заключение

В тот момент, когда Tesla V100 был интегрирован в сервер клиента, это было похоже на высвобождение дремлющей электростанции. Производительность сервера не просто улучшилась — она взлетела до небес, разрушив ограничения традиционных процессоров. Благодаря исключительным возможностям графического процессора Tesla V100 сервер приобрел беспрецедентную мощность и пропускную способность, с легкостью преодолев ограничения однопроцессорных систем.

Этот скачок в технологиях касался не только аппаратного обеспечения; речь шла о преобразовании всего проекта ИИ клиента. Наш инновационный подход к оптимизации конфигурации серверов стал основой их успеха. Когда языковая модель искусственного интеллекта была запущена на сервере клиента, результаты оказались просто впечатляющими:

Непревзойденное качество обслуживания

Способность ИИ давать быстрые и точные ответы совершила квантовый скачок. Пользователи стали получать более быстрые и точные ответы, а модель ловко справлялась даже с самыми сложными запросами. Это было не просто обновление, это была революция в удовлетворении пользователей и повышении качества обслуживания.

Повышенная производительность

Обучение модели ИИ стало оптимизированным и эффективным процессом благодаря огромной вычислительной мощности, находящейся в ее распоряжении. Большие наборы данных, которые когда-то утомляли системы, теперь обрабатывались с головокружительной скоростью, что сокращало время обучения и ускоряло эволюцию модели. Реализация ИИ была быстрее, плавнее и эффективнее, чем когда-либо прежде.

Безграничная масштабируемость

Серверная архитектура, которую мы создали, была создана не только для сегодняшнего дня, она была спроектирована для будущего. Благодаря масштабируемости, заложенной в его основу, клиент мог легко расширять свой проект по мере роста базы пользователей и увеличения требований. Такая гибкость гарантировала, что ИИ сможет развиваться вместе с амбициями клиента без необходимости кардинальных технических изменений.

В конце концов, это был не просто проект — это был триумф. Интегрировав модель языка искусственного интеллекта на свой сервер, клиент получил три преимущества: значительно улучшенное качество обслуживания, повышенная производительность и добавленная надежная масштабируемость. Эти достижения не просто оправдали ожидания; они устанавливают новый стандарт того, что возможно, когда передовые технологии сочетаются с дальновидным исполнением. Будущее искусственного интеллекта наступило, и оно было ярче, чем когда-либо.