Obiettivi e risultati

Il contesto

Nel cuore della Germania, in un vivace polo tecnologico, c'era una startup audace con una visione che avrebbe potuto rimodellare il panorama digitale. Questa azienda innovativa, nota per il suo lavoro all'avanguardia nel campo dell'intelligenza artificiale, aveva puntato a qualcosa di veramente straordinario. Voleva creare un modello linguistico di intelligenza artificiale in grado di competere con il leggendario ChatGPT, ma con una particolarità: doveva funzionare interamente sulla propria rete.

Non si trattava di un progetto qualsiasi. La startup aveva già fatto scalpore con la sua rivoluzionaria app, un chatbot elegante e sofisticato progettato per replicare una conversazione simile a quella umana. Immaginate un compagno digitale così intuitivo e acuto da comprendere le vostre domande e rispondere con le stesse sfumature e profondità di un esperto.

Ma come ci sono riusciti? Il segreto risiede nella loro padronanza dell'apprendimento automatico. Avevano sviluppato algoritmi complessi che consentivano alla loro IA di imparare il linguaggio da grandi quantità di dati, riconoscendo schemi e prendendo decisioni al volo. A differenza del software tradizionale, che deve essere programmato per ogni possibile scenario, la loro IA poteva pensare da sola, adattandosi ed evolvendosi a ogni nuova interazione.

L'applicazione si era già guadagnata la reputazione di fornire risposte fulminee anche alle domande più difficili. La sua base di conoscenze era ampia e attingeva da un internet di informazioni per fornire agli utenti risposte precise e contestuali. Che si tratti di domande sui misteri dell'universo o sulle ultime tendenze della tecnologia, l'intelligenza artificiale è in grado di rispondere.

Man mano che la startup continuava a perfezionare la sua creazione, è diventato chiaro che si trovava sull'orlo di qualcosa di rivoluzionario. Il loro strumento di intelligenza artificiale non si limitava a rispondere alle domande, ma trasformava il modo in cui le persone interagiscono con le informazioni. Con la sua interfaccia facile da usare e la sua impareggiabile precisione, è diventato rapidamente una risorsa indispensabile per chiunque abbia bisogno di risposte rapide e affidabili.

Il sogno della startup tedesca era più di un semplice risultato tecnico, era un balzo in avanti nel modo in cui comprendiamo e utilizziamo l'intelligenza artificiale e, mentre si preparavano a dare vita alla loro visione sui propri server, sapevano che stavano per fare la storia.

Il problema

La posta in gioco era alta. Il cliente, un visionario nel mondo dell'IA, aveva un sogno che richiedeva niente di meno che una tecnologia all'avanguardia. Aveva bisogno di un server - un gigante di potenza di calcolo - in grado di tenere testa ai titani del mondo dell'IA: LLaMA di Meta, Gemini e Mistral di Google. Non si tratta di modelli linguistici qualsiasi, ma dei vertici dell'IA moderna, che richiedono un'immensa potenza di calcolo per elaborare e analizzare i dati di una rete internet con la massima precisione.

Nel mondo dell'IA, la potenza non è solo un lusso, ma una necessità. Il cliente sapeva che per sfruttare appieno il potenziale di questi modelli, il suo server doveva essere un motore, in grado di gestire carichi di lavoro intensi senza nemmeno un tremolio di instabilità. Il minimo inconveniente potrebbe portare al disastro, interrompendo il flusso continuo di informazioni e causando frustranti ritardi o, peggio, risultati imprecisi. Ma con il server giusto, costruito per resistere ed eccellere, il cliente poteva liberare tutta la potenza della sua soluzione di intelligenza artificiale, fornendo risposte fulminee e affidabili ogni volta.

Tuttavia, l'esigenza di potenza non si limitava alle prestazioni grezze. Il cliente sapeva anche che il mondo dell'IA è in continua evoluzione, con nuove conoscenze e scoperte che emergono a un ritmo incessante. Per essere all'avanguardia, la loro soluzione di IA doveva evolversi altrettanto rapidamente, incorporando gli ultimi progressi per rimanere nitida, pertinente e sorprendentemente precisa. Ciò significava aggiornamenti regolari e un impegno costante verso la perfezione. Inoltre, solo un server con la capacità di effettuare aggiornamenti continui ed efficienti poteva garantire che l'IA rimanesse all'avanguardia, sempre pronta a rispondere alla prossima grande domanda.

Per questo cliente, il server non era solo hardware: era la mente del suo impero AI, la chiave per trasformare una visione in realtà. Con un server in grado di soddisfare queste immense esigenze, il cliente non solo avrebbe spinto i confini di ciò che l'IA poteva fare, ma avrebbe anche ridefinito il futuro della tecnologia intelligente.

La soluzione

Nel mondo dell'intelligenza artificiale, la velocità è tutto. Quando si tratta di gestire un modello linguistico di IA, la capacità di elaborare le informazioni alla velocità della luce può fare la differenza tra genialità e mediocrità. La sfida è immensa: setacciare un'infinità di dati, analizzarli in tempo reale e fornire intuizioni con precisione, il tutto in un batter d'occhio.

Per essere all'altezza di questa sfida, sapevamo di aver bisogno di qualcosa di più di un sistema potente: avevamo bisogno di un capolavoro tecnologico. Per questo motivo abbiamo scelto un server dotato di GPU NVIDIA Tesla V100, una macchina straordinaria nota per le sue prestazioni ineguagliabili. Non si tratta di una GPU qualsiasi: è la punta di diamante della gamma NVIDIA, dotata dell'avanzata tecnologia Tensor Core che porta l'elaborazione dell'intelligenza artificiale a un livello superiore.

Immaginate una macchina così potente da poter affrontare con facilità i compiti più complessi dell'intelligenza artificiale, sminuzzando senza sforzo i dati a velocità sbalorditive. Tesla V100 è stata progettata per gestire le esigenze dell'IA moderna e rappresenta la scelta perfetta per qualsiasi scenario in cui l'elaborazione rapida e ad alto volume di dati è irrinunciabile. Con questa GPU al centro, il modello linguistico dell'IA diventa una forza da non sottovalutare, in grado di fornire risultati più rapidi e accurati che mai.

Nelle mani di questa potenza, l'IA non è solo reattiva, ma è anche sovralimentata, pronta ad affrontare le sfide più intricate con finezza. Tesla V100 non si limita a soddisfare i requisiti dell'intelligenza artificiale, ma li supera, stabilendo un nuovo standard per ciò che è possibile fare nel mondo della tecnologia intelligente.

Il processo di scelta della configurazione del server

Tornando al processo di selezione della configurazione server ideale per il nostro cliente, esso si è svolto come segue:

Dopo aver raccolto con attenzione le informazioni necessarie dal cliente in merito alle attività desiderate, abbiamo fornito una configurazione su misura che soddisfa i requisiti specifici e garantisce un'elaborazione efficiente di grandi quantità di dati per l'addestramento dei modelli di intelligenza artificiale.

La configurazione iniziale che abbiamo proposto era la seguente (si noti che può essere personalizzata in base alle preferenze del cliente):

-Processore: 2 x Intel Xeon Gold 6248R

-RAM: 512 GB DDR4

- Storage: 4 TB SSD NVMe

- Schede grafiche: 4x NVIDIA Tesla V100

Prima di consegnare la soluzione server finale, è stato necessario perfezionare ulteriormente la configurazione server orientata al cliente. A tal fine, abbiamo avviato un'indagine per raccogliere informazioni sui seguenti aspetti:

- La quantità prevista di dati da elaborare e addestrare sul modello di intelligenza artificiale.

- Preferenze relative a GPU specifiche e altri componenti importanti.

Dopo aver ricevuto ulteriori input dal cliente in merito al volume di dati e alle preferenze hardware, abbiamo proposto una configurazione finale del server che soddisfa i seguenti requisiti specifici.

- Noleggio del server: Considerando i requisiti iniziali del cliente, la configurazione richiedeva processori potenti, una grande quantità di RAM e diverse schede grafiche.

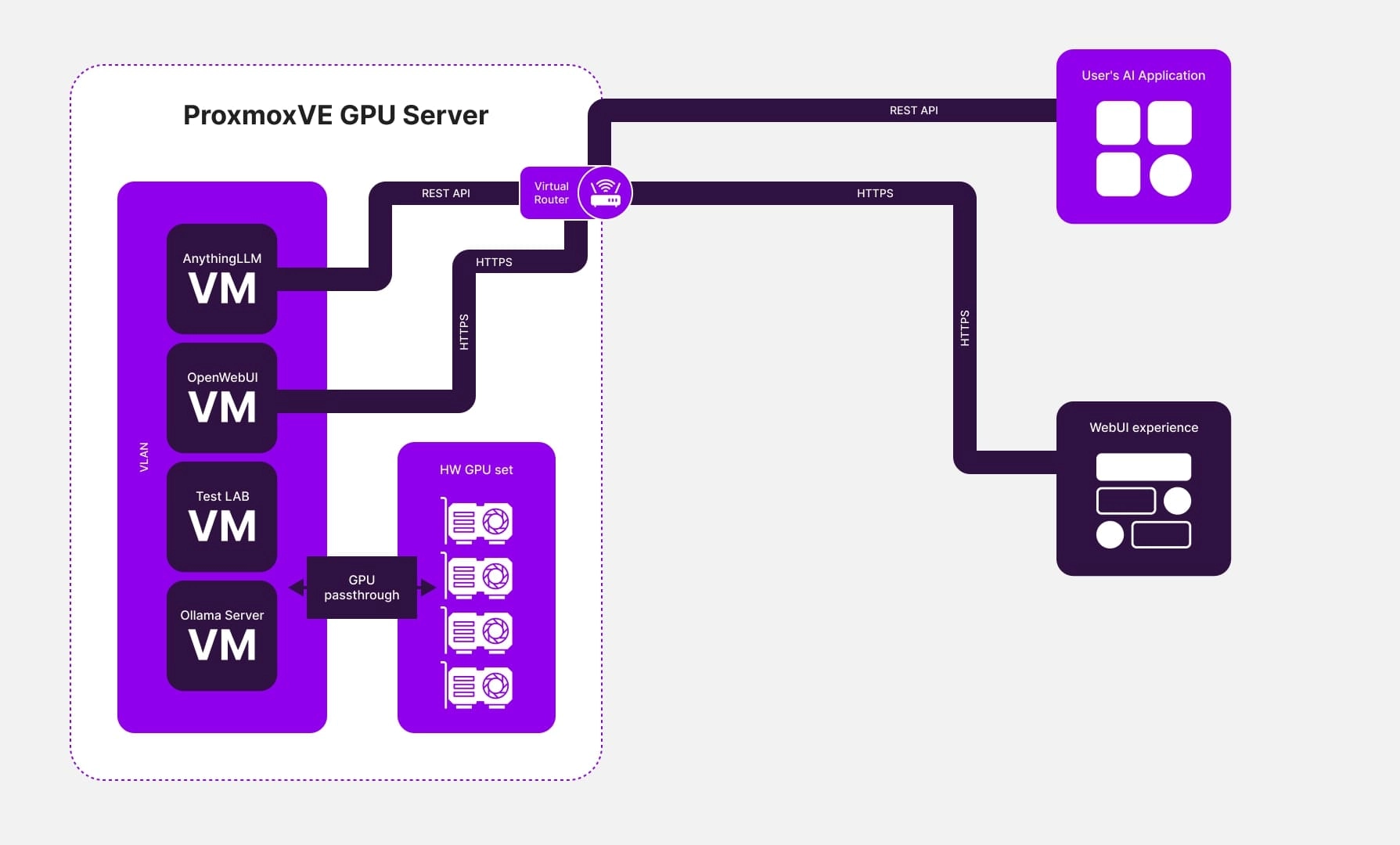

- Uso del software di virtualizzazione: Per soddisfare le esigenze del cliente, abbiamo implementato un'infrastruttura basata sulla virtualizzazione. Questa configurazione comprendeva più macchine virtuali, ognuna dotata di un proprio adattatore grafico.

- Installazione dei server del modello linguistico: I server dei modelli linguistici Ollama e OpenWebUI sono stati installati sulle macchine virtuali, insieme a un server che forniva l'accesso a un'interfaccia web facile da usare e sicura per la gestione dei modelli linguistici, come AnythingLLM. AnythingLLM offriva anche l'accesso alle API per l'integrazione con altri sviluppi client.

- Lancio del modello: Il cliente ha lanciato con successo il proprio modello di intelligenza artificiale, garantendo un funzionamento stabile e prestazioni elevate sul server.

Conclusione

Nel momento in cui Tesla V100 è stato integrato nel server del cliente, è stato come liberare una centrale elettrica inattiva. Le prestazioni del server non sono solo migliorate, ma sono salite alle stelle, abbattendo i limiti delle CPU tradizionali. Grazie alle straordinarie capacità della GPU Tesla V100, il server ha acquisito una potenza e un throughput senza precedenti, superando con facilità i limiti dei sistemi a singola CPU.

Questo salto tecnologico non riguardava solo l'hardware: si trattava di trasformare l'intero progetto di intelligenza artificiale del cliente. Il nostro approccio innovativo all'ottimizzazione della configurazione dei server è diventato la spina dorsale del loro successo. Quando il modello linguistico di IA è entrato in funzione su questo server turbo, i risultati sono stati a dir poco spettacolari:

- Qualità del servizio senza precedenti

La capacità dell'intelligenza artificiale di fornire risposte rapide e precise ha fatto un salto di qualità. Gli utenti hanno iniziato a sperimentare risposte più rapide e precise, con il modello in grado di gestire abilmente anche le query più complesse. Non si è trattato di un semplice aggiornamento, ma di una rivoluzione nella soddisfazione degli utenti e nelle prestazioni del servizio.

- Prestazioni potenziate

L'addestramento del modello AI è diventato un processo snello ed efficiente, grazie all'immensa potenza di calcolo a disposizione. I grandi insiemi di dati che prima impantanavano i sistemi sono stati ora elaborati a una velocità impressionante, riducendo i tempi di formazione e accelerando l'evoluzione del modello. L'implementazione dell'intelligenza artificiale è stata più veloce, più fluida e più efficace che mai.

- Scalabilità senza limiti

L'architettura del server che abbiamo realizzato non è stata costruita solo per oggi, ma è stata progettata per il futuro. Con la scalabilità incorporata nel suo nucleo, il cliente ha potuto espandere senza problemi il suo progetto con la crescita della base di utenti e l'aumento delle richieste. Questa flessibilità ha garantito che l'intelligenza artificiale potesse evolvere insieme alle ambizioni del cliente, senza bisogno di drastiche revisioni tecniche.

Alla fine, non si è trattato solo di un progetto, ma di un trionfo. Integrando il modello linguistico dell'intelligenza artificiale nel proprio server, il cliente ha ottenuto una triplice serie di vantaggi: una qualità del servizio nettamente migliore, prestazioni più elevate e una robusta scalabilità. Questi risultati non si sono limitati a soddisfare le aspettative, ma hanno stabilito un nuovo standard per ciò che è possibile fare quando la tecnologia all'avanguardia incontra un'esecuzione visionaria. Il futuro dell'IA era arrivato, ed era più luminoso che mai.