Objectifs et résultats

Le contexte

Au cœur de l'Allemagne, dans un centre technologique en pleine effervescence, il y avait une startup audacieuse avec une vision qui pourrait remodeler le paysage numérique. Cette entreprise innovante, connue pour ses travaux de pointe dans le domaine de l'intelligence artificielle, avait pour objectif de réaliser quelque chose de vraiment extraordinaire. Elle souhaitait créer un modèle linguistique d'IA capable de rivaliser avec le légendaire ChatGPT, mais avec une particularité : il devait fonctionner entièrement sur son propre réseau.

Il ne s'agissait pas d'un projet ordinaire. La startup avait déjà fait parler d'elle avec son application révolutionnaire, un chatbot élégant et sophistiqué conçu pour reproduire une conversation humaine. Imaginez un compagnon numérique si intuitif, si perspicace, qu'il pourrait comprendre vos questions et y répondre avec la même nuance et la même profondeur qu'un expert chevronné.

Mais comment ont-ils fait ? Le secret réside dans leur maîtrise de l'apprentissage automatique. Ils avaient mis au point des algorithmes complexes qui permettaient à leur IA d'apprendre le langage à partir de grandes quantités de données, en reconnaissant des modèles et en prenant des décisions à la volée. Contrairement aux logiciels traditionnels qui doivent être programmés pour tous les scénarios possibles, leur IA pouvait penser par elle-même, s'adaptant et évoluant à chaque nouvelle interaction.

L'application avait déjà acquis la réputation de fournir des réponses rapides comme l'éclair aux questions les plus difficiles. Sa base de connaissances était vaste, puisant dans une multitude d'informations pour fournir aux utilisateurs des réponses précises et adaptées au contexte. Que vous vous interrogiez sur les mystères de l'univers ou sur les dernières tendances technologiques, cette IA vous couvre.

Au fur et à mesure que la startup affinait sa création, il est devenu évident qu'elle était sur le point de réaliser quelque chose de révolutionnaire. Leur outil d'IA ne se contentait pas de répondre à des questions ; il s'agissait de transformer la manière dont les gens interagissaient avec l'information. Grâce à son interface conviviale et à sa précision inégalée, il est rapidement devenu une ressource indispensable pour tous ceux qui ont besoin de réponses rapides et fiables.

Le rêve de la startup allemande était plus qu'une simple réalisation technique, c'était un bond en avant dans la façon dont nous comprenons et utilisons l'IA, et alors qu'ils se préparaient à donner vie à leur vision sur leurs propres serveurs, ils savaient qu'ils étaient sur le point d'entrer dans l'histoire.

Problème

L'enjeu était de taille. Le client, un visionnaire dans le monde de l'IA, avait un rêve qui n'exigeait rien de moins qu'une technologie de pointe. Il avait besoin d'un serveur - un mastodonte de puissance de calcul - capable de tenir tête aux titans du monde de l'IA : LLaMA de Meta, Gemini de Google et Mistral. Il ne s'agit pas de n'importe quels modèles de langage, mais des sommets de l'IA moderne, qui requièrent une immense puissance de calcul pour traiter et analyser l'équivalent d'un internet de données avec une précision extrême.

Dans le monde de l'IA, la puissance n'est pas un luxe, c'est une nécessité. Le client savait que pour exploiter tout le potentiel de ces modèles, son serveur devait être un véritable moteur, capable de gérer des charges de travail intenses sans le moindre signe d'instabilité. Le moindre pépin peut s'avérer catastrophique et perturber le flux continu d'informations, entraînant des retards frustrants ou, pire encore, des résultats inexacts. Mais avec le bon serveur, un serveur conçu pour durer et exceller, le client pouvait libérer toute la puissance de sa solution d'IA, en fournissant des réponses rapides comme l'éclair et fiables à chaque fois.

Mais le besoin de puissance ne s'arrête pas aux performances brutes. Le client a également compris que le monde de l'IA est en constante évolution, avec de nouvelles connaissances et des percées qui émergent à un rythme effréné. Pour garder une longueur d'avance, sa solution d'IA devait évoluer tout aussi rapidement, en intégrant les dernières avancées pour rester pointue, pertinente et étonnamment précise. Cela impliquait des mises à jour régulières et un engagement permanent en faveur de la perfection. De plus, seul un serveur capable d'effectuer des mises à jour continues et efficaces pouvait garantir que l'IA reste à la pointe de la technologie, toujours prête à répondre à la prochaine grande question.

Pour ce client, le serveur n'était pas qu'un simple matériel ; c'était l'esprit de son empire de l'IA, la clé pour transformer une vision en réalité. Avec un serveur capable de répondre à ces immenses exigences, le client allait non seulement repousser les limites de ce que l'IA pouvait faire, mais aussi redéfinir l'avenir de la technologie intelligente.

La solution

Dans le monde de l'IA, où les enjeux sont considérables, la vitesse est primordiale. Lorsqu'il s'agit de faire fonctionner un modèle de langage d'IA, la capacité à traiter l'information à la vitesse de l'éclair peut faire la différence entre la brillance et la médiocrité. Le défi est immense : il s'agit de passer au crible une masse de données, de les analyser en temps réel et de fournir des informations précises, le tout en un clin d'œil.

Pour relever ce défi, nous savions qu'il nous fallait plus qu'un système puissant, il nous fallait un chef-d'œuvre technologique. C'est pourquoi nous avons choisi un serveur équipé du GPU NVIDIA Tesla V100, une bête de machine connue pour ses performances inégalées. Il ne s'agit pas de n'importe quel GPU, mais du summum de la gamme NVIDIA, doté de la technologie avancée Tensor Core qui fait passer le traitement de l'IA au niveau supérieur.

Imaginez une machine si puissante qu'elle peut s'attaquer aux tâches d'IA les plus complexes avec facilité, en traitant sans effort les données à des vitesses époustouflantes. Le Tesla V100 est conçu pour répondre aux exigences de l'IA moderne, ce qui en fait le choix idéal pour tous les scénarios où le traitement rapide de gros volumes de données n'est pas négociable. Grâce à ce GPU, le modèle de langage de l'IA devient une force avec laquelle il faut compter, capable de fournir des résultats plus rapides et plus précis que jamais.

Entre les mains de cette centrale, l'IA n'est pas seulement réactive - elle est suralimentée, prête à relever les défis les plus complexes avec finesse. Le Tesla V100 ne se contente pas de répondre aux exigences de l'IA, il les dépasse, établissant une nouvelle norme pour ce qui est possible dans le monde de la technologie intelligente.

Le processus de sélection de la configuration du serveur

Pour en revenir au processus de sélection de la configuration de serveur idéale pour notre client, il s'est déroulé comme suit :

Après avoir soigneusement recueilli les informations nécessaires auprès du client concernant les tâches qu'il souhaite accomplir, nous lui avons proposé une configuration sur mesure répondant à ses besoins spécifiques et garantissant un traitement efficace de grandes quantités de données pour l'entraînement des modèles d'IA.

La configuration initiale que nous avons proposée était la suivante (à noter qu'elle peut être personnalisée en fonction des préférences du client) :

-Processeur : 2 x Intel Xeon Gold 6248R

-RAM : 512 GB DDR4

- Stockage : 4 TB SSD NVMe

- Cartes graphiques : 4x NVIDIA Tesla V100

Avant de livrer la solution serveur finale, il était nécessaire d'affiner la configuration serveur orientée client. Pour ce faire, nous avons lancé une enquête afin de recueillir des informations sur les aspects suivants :

- La quantité prévue de données à traiter et à entraîner sur le modèle d'IA.

- Les préférences concernant les GPU spécifiques et d'autres composants importants.

Après avoir reçu des informations supplémentaires de la part du client concernant son volume de données et ses préférences en matière de matériel, nous avons proposé une configuration de serveur finale qui répondait aux exigences spécifiques suivantes.

- Location du serveur : Compte tenu des exigences initiales du client, la configuration nécessitait des processeurs puissants, une grande quantité de mémoire vive et plusieurs cartes graphiques.

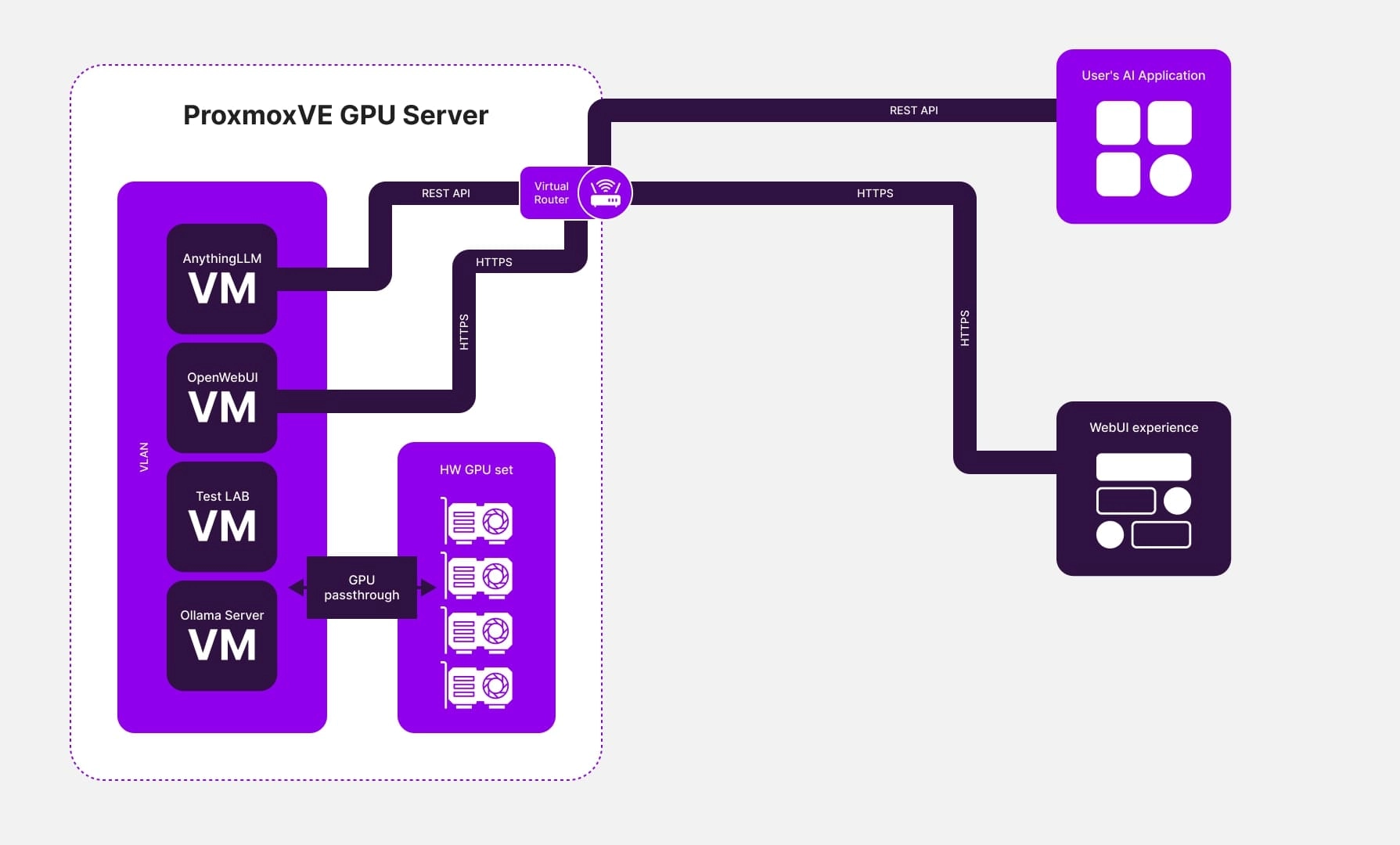

- Utilisation d'un logiciel de virtualisation : Pour répondre aux besoins du client, nous avons mis en place une infrastructure basée sur la virtualisation. Cette configuration comprenait plusieurs machines virtuelles, chacune équipée de ses propres adaptateurs graphiques.

- Installation de serveurs de modèles linguistiques : Les serveurs de modèles de langue Ollama et OpenWebUI ont été installés sur les machines virtuelles, ainsi qu'un serveur permettant d'accéder à une interface web conviviale et sécurisée pour gérer les modèles de langue, tel que AnythingLLM. AnythingLLM offrait également un accès à l'API pour l'intégration avec d'autres développements clients.

- Lancement du modèle : Le client a lancé avec succès son modèle d'intelligence artificielle, en assurant un fonctionnement stable et des performances élevées sur le serveur.

Conclusion

Le moment où la Tesla V100 a été intégrée dans le serveur du client a été comme la libération d'une puissance dormante. Les performances du serveur ne se sont pas contentées de s'améliorer, elles sont montées en flèche, pulvérisant les limites des processeurs traditionnels. Grâce aux capacités extraordinaires du GPU Tesla V100, le serveur a bénéficié d'une puissance et d'un débit sans précédent, dépassant facilement les contraintes des systèmes à CPU unique.

Ce saut technologique n'était pas qu'une question de matériel ; il s'agissait de transformer l'ensemble du projet d'IA du client. Notre approche innovante de l'optimisation de la configuration du serveur est devenue l'épine dorsale de leur succès. Lorsque le modèle de langage d'IA a été mis en service sur ce serveur turbocompressé, les résultats ont été tout simplement spectaculaires :

- Une qualité de service inégalée

La capacité de l'IA à fournir des réponses rapides et précises a fait un bond en avant. Les utilisateurs ont commencé à obtenir des réponses plus rapides et plus précises, le modèle s'attaquant habilement aux requêtes les plus complexes. Il ne s'agissait pas d'une simple mise à niveau, mais d'une révolution dans la satisfaction des utilisateurs et la performance des services.

- Des performances accrues

L'entraînement du modèle d'IA est devenu un processus rationalisé et efficace, grâce à l'immense puissance de calcul dont il dispose. Les grands ensembles de données, qui paralysaient auparavant les systèmes, étaient désormais traités à une vitesse fulgurante, réduisant les temps de formation et accélérant l'évolution du modèle. La mise en œuvre de l'IA a été plus rapide, plus fluide et plus efficace que jamais.

- Évolutivité illimitée

L'architecture de serveur que nous avons conçue n'a pas seulement été pensée pour aujourd'hui, elle a été conçue pour l'avenir. Grâce à l'évolutivité de l'architecture, le client a pu étendre son projet sans effort au fur et à mesure que sa base d'utilisateurs augmentait et que les demandes se multipliaient. Cette flexibilité a permis à l'IA d'évoluer en même temps que les ambitions du client, sans qu'il soit nécessaire de procéder à des révisions techniques radicales.

En fin de compte, il ne s'agissait pas seulement d'un projet, mais d'un triomphe. En intégrant le modèle linguistique de l'IA à son propre serveur, le client a obtenu trois avantages : une qualité de service nettement améliorée, des performances accrues et une évolutivité plus robuste. Ces réalisations n'ont pas seulement répondu aux attentes ; elles ont établi une nouvelle norme pour ce qui est possible lorsque la technologie de pointe rencontre une exécution visionnaire. L'avenir de l'IA était arrivé, et il était plus brillant que jamais.